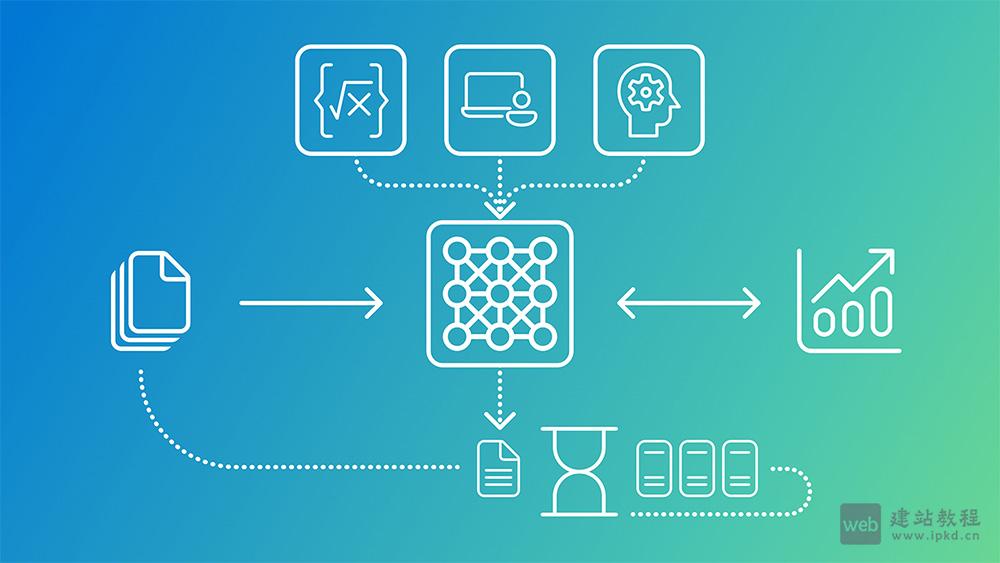

Phi-4-reasoning-vision-15B模型核心优势集中在GUI界面理解、数学科学推理、文档图表分析三大领域,推理速度较同类大模型快10倍以上,同时在AI2D、ChartQA、MathVista等权威基准测试中表现亮眼,展现出“小参数量、高性能、低延迟”的核心竞争力。

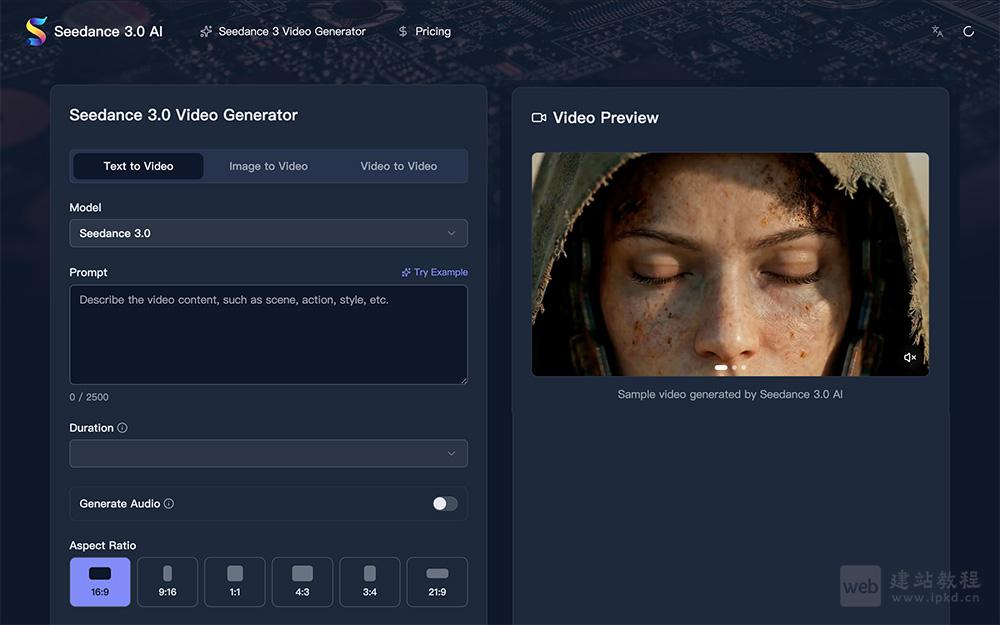

Seedance 3.0 AI是一款免费AI视频生成器,核心定位是帮助用户轻松创建4K电影级视频,无需专业技能即可实现高质量创作。它搭载多镜头叙事、原生音频同步、角色一致性等实用功能,广泛适配内容创作者、电影制作人、营销团队等群体,完美匹配各类视频创作需求。

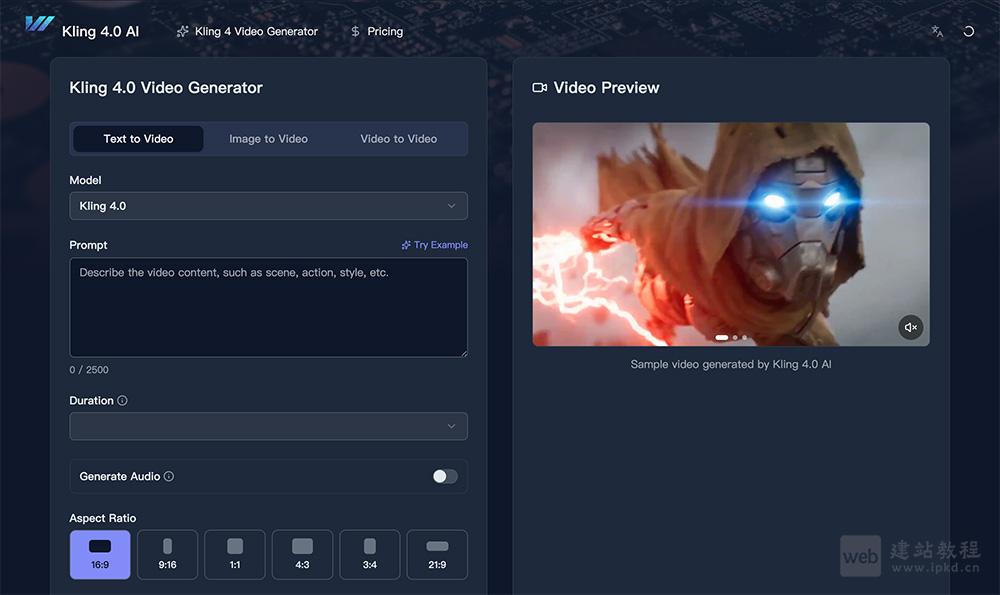

Kling 4.0是由Kling AI Models推出的下一代AI视频模型,凭借先进的AI技术,用户只需输入简单文本提示,即可快速生成专业电影级视频与4K高清图像。它核心为内容创作者、电影制作人、营销专业人士提供强大的视频创作支撑,大幅加速创意工作流程,降低专业视频制作的门槛与成本。

Sprite AI核心优势的是无需用户具备任何绘画技能,只需输入文本描述,即可快速生成高质量像素艺术精灵;产品提供多种灵活订阅计划,价格从每月5美元起,涵盖游戏新手、独立开发者、专业团队等不同人群的需求,且支持随时取消订阅,兼顾实用性与灵活性。

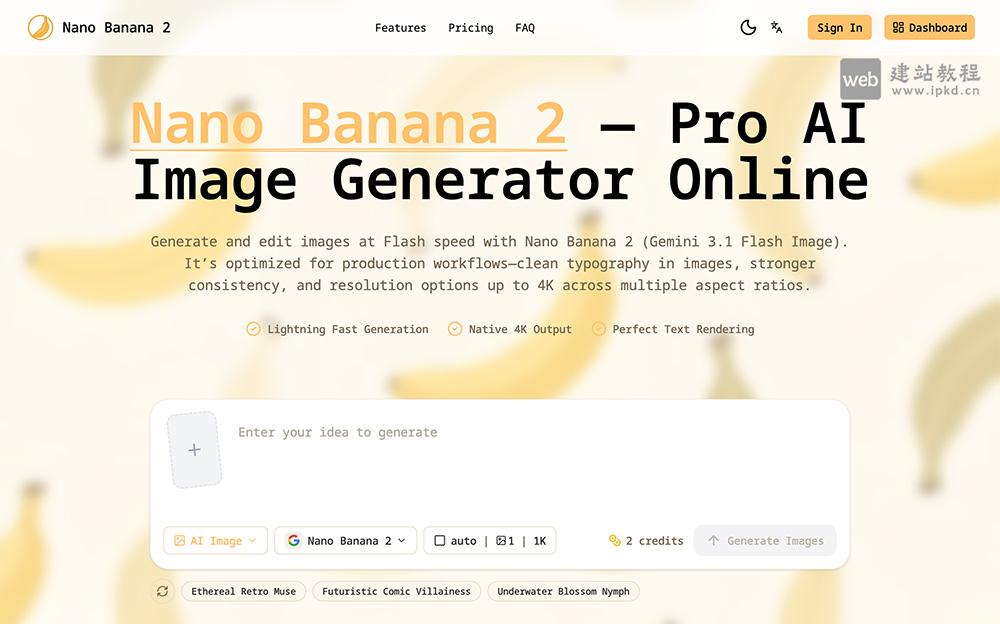

Nano Banana 2可帮助用户快速将创意想法转化为高质量图像。它核心聚焦电商、社交创意等领域,提供高效的图像创作解决方案,凭借闪电级生成速度、原生4K高清输出、完美文本渲染等核心优势,兼顾专业性与易用性。

平台定位清晰,既是用户快速找到优质AI工具的“导航仪”,也是AI创作者展示创新成果、触达目标受众的“展示台”,价格暂未明确提及,核心聚焦于解决AI工具筛选难、创作者曝光难的核心痛点。

产品核心定位是满足人们对家居设计的个性化需求,打破专业设计的门槛,让普通人也能轻松实现房间改造设想,同时为室内设计师、房地产从业者提供高效辅助,助力快速打造令人惊艳的空间。目前产品完全免费,每天提供5次免费生成机会,兼顾实用性与便捷性。

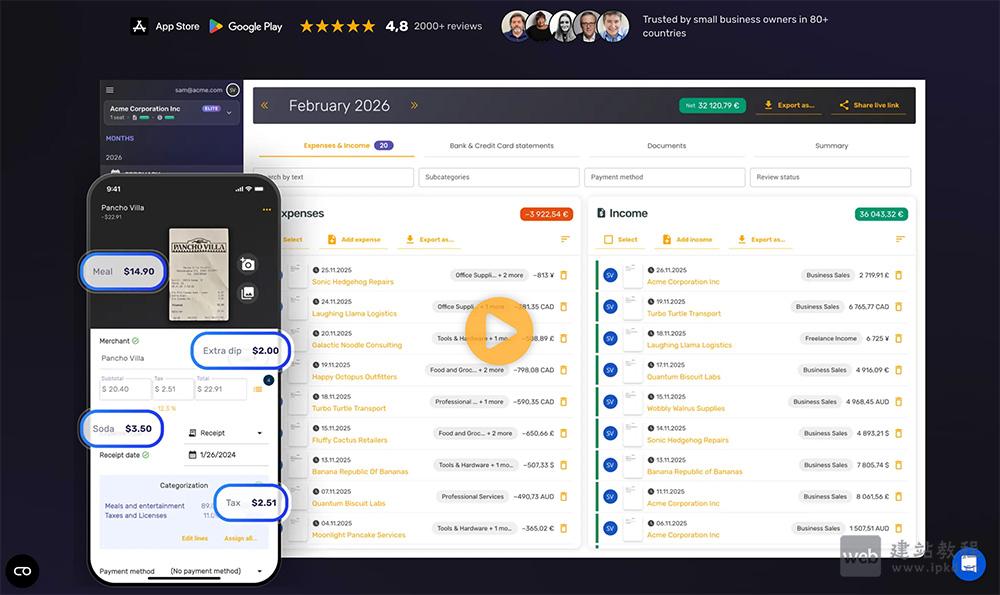

SparkReceipt是一款由人工智能驱动的专业收据扫描与费用跟踪工具,核心面向自由职业者、小企业及财务管理人员,专注解决收据管理繁琐、费用统计低效的痛点。它通过AI技术实现收据快速精准扫描与信息提取,支持多语言适配,可免费使用,精准满足

FormHug是一款由人工智能驱动的全能表单构建器,无需编码、无需设计基础,即可快速创建适配多场景的表单,广泛应用于活动注册、市场调查、测验评估、预约预订等各类需求。

在Worfbench、BFCL-v3等权威智能体基准测试中,效果超越GPT-5.2、Kimi-K2等千亿级模型,是业界首个具备全场景泛化规划能力的轻量化智能体模型,目前已落地荣耀Magic系列手机。

GPT‑5.3 Instant是OpenAI推出的新一代轻量级对话模型,专为更自然、可靠、流畅的日常聊天体验设计。模型大幅改善“说教、啰嗦”等机械表达,回答更直接简洁;联网搜索整合能力显著增强,可结合知识图谱提供深度分析,而非简单罗列链接。

Gemini 3.1 Flash-Lite是Google推出的轻量级旗舰大模型,主打极致速度与超高性价比。模型支持可调思考深度,适合高频翻译、内容审核、实时UI生成等场景,目前已通过Google AI Studio和Vertex AI开放预览。

MiniMax Music 2.5+是MiniMax全新升级的AI音乐生成模型,专注高品质纯音乐创作。模型支持古典管弦、电子、氛围、自然声景等多元风格,可一键产出冥想、助眠、游戏、影视、广告等全场景配乐。

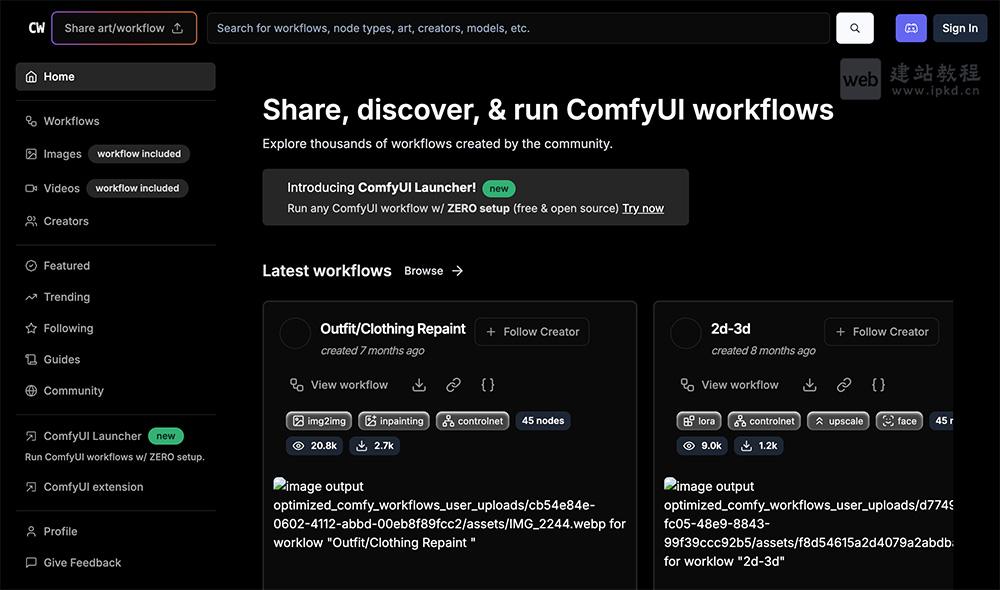

Comfy Workflows致力于打破传统工作流程管理的限制,为AI创作社区提供一个开放、自由的资源库。它不仅是一个工作流设计工具(类似于ComfyUI),更是一个知识分享平台,用户可以在这里浏览、搜索并运行由他人创建的图像生成脚本,而无需繁琐的注册或登录过程。

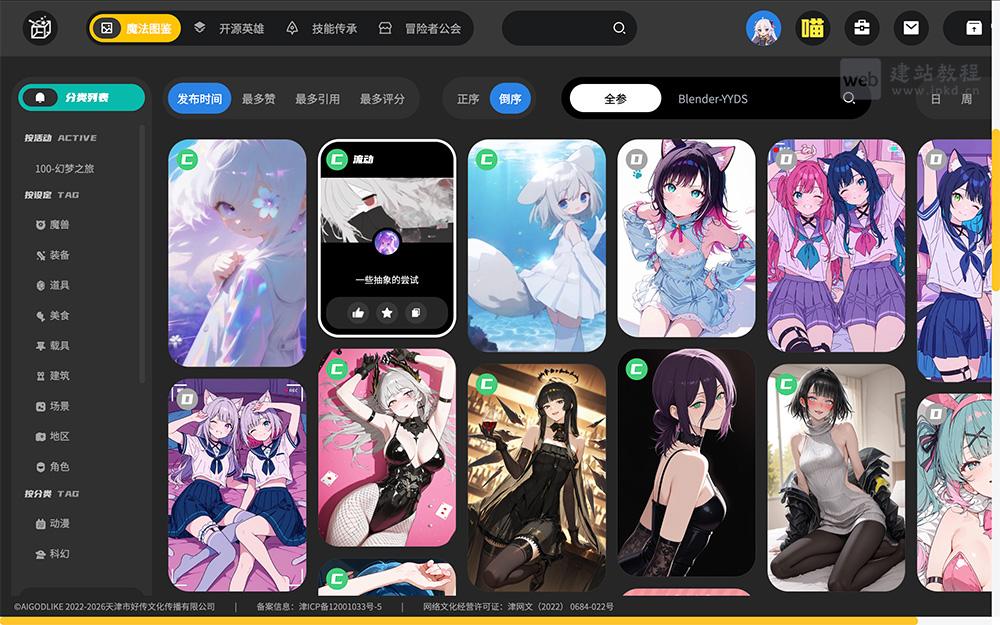

AIGODLIKE是一个开源的AI冒险社区与平台,旨在为AI爱好者、开发者和创作者提供一个协作、学习与资源共享的生态系统。它不仅是一个技术社区,更融入了游戏化的“冒险”概念,通过资源图鉴和插件系统,降低了AI技术的使用门槛。